Vous en avez sans doute entendu parler : l’AI Act a été officiellement adopté par le Parlement européen et le texte est entré en vigueur le 1er Août 2024. À l’image du RGPD en son temps, cette nouvelle réglementation marque un tournant majeur dans le domaine de l’intelligence artificielle et de la Data, et va profondément impacter nos pratiques en tant que professionnels de la Data.

Pour les data scientists, cela veut dire repenser nos méthodes de travail et nos best practices afin de garantir la conformité avec ce nouveau cadre légal. Mais face à la complexité du texte et à la multitude d’annonces autour de son adoption, il n’est pas facile de s’y retrouver.

Cette série d’articles a pour but de mieux comprendre ce qu’est l’AI Act et d’en extraire les éléments clés qui concernent directement notre métier. L’objectif est de vous aider, en tant que praticien de la data, à comprendre ce que prévoit la réglementation, à identifier les obligations qui en découlent et à adapter vos pratiques en conséquence.

Dans ce premier article, nous explorerons d’abord les fondamentaux :

-

Qu’est-ce que l’AI Act et pourquoi a-t-il été mis en place ?

-

Comment y est défini un système d’intelligence artificielle ?

-

Qui sont les acteurs concernés et à quel moment sont-ils impliqués ?

-

Quelle est l’approche de catégorisation par niveau de risque ?

-

Et enfin, comment la loi sera-t-elle mise en œuvre dans le temps, par quelles instances, et avec quelles conséquences en cas de non-conformité ?

I. Qu’est-ce que l’AI Act et pourquoi a-t-il été créé ?

L’AI Act est donc le premier cadre juridique complet de l’Union européenne visant à encadrer le développement, la commercialisation et l’utilisation des systèmes d’intelligence artificielle (IA) au sein des États membres.

Son ambition principale : s’assurer que les systèmes d’IA soient dignes de confiance, qu’ils respectent la santé, la sécurité et les droits fondamentaux des citoyens européens, tout en favorisant l’innovation technologique, éthique et responsable.

Le texte encadre non seulement la mise sur le marché et la mise en service des systèmes d’IA, mais aussi leur utilisation concrète. Pour ce faire, il repose sur une approche fondée sur le niveau de risque que représente un système d’IA selon son cas d’usage. À chaque niveau de risque correspondent des obligations que doivent respecter différents acteurs du cycle de vie de l’IA. Nous détaillerons cette catégorisation plus loin dans l’article.

Enfin, l’AI Act accorde une attention particulière aux GPAI modèles : les General Purpose AI models, ou modèles d’IA à usage général, en raison de leur impact transversal sur de nombreux domaines d’application.

II. Comment l’AI Act définit-il un « système d’IA » ?

On le sait : le terme « Intelligence Artificielle » peut évoquer différentes choses en fonction de la personne à laquelle on s’adresse. C’est pourquoi il est fondamental de comprendre précisément ce que l’AI Act entend par système d’IA, afin de savoir à quels cas et à quelles pratiques cette réglementation s’applique réellement.

Pour cela, on peut se référer à l’article 3 du texte. Voici comment un système d’IA y est décrit :

“‘AI system’ means a machine-based system that is designed to operate with varying levels of autonomy and that may exhibit adaptiveness after deployment, and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments;“

Cette définition permet de dégager plusieurs critères clés pour qu’un système entre dans le champ d’application de l’AI Act :

-

Il s’agit d’abord d’un système et non pas d’un simple modèle.

-

Il se base sur des machines et non pas sur un traitement humain.

-

Il présente un certain niveau d’autonomie et peut faire preuve d’adaptabilité après son déploiement, ce qui sous-entend une capacité d’apprentissage ou d’ajustement, et non pas une simple suite d’instructions fixes.

-

Enfin, ses résultats doivent avoir un impact potentiel sur le monde réel ou virtuel.

On peut donc en déduire que tout système intégrant un modèle de Machine Learning, de Deep Learning, ou utilisant un LLM (Large Language Model) à un moment donné de son fonctionnement, sera considéré comme un système d’IA au sens de l’AI Act.

À l’inverse, un système basé uniquement sur des règles statiques ou une logique déterministe ne rentre pas dans ce périmètre.

Le texte précise aussi ce qu’il entend par le terme “risque”, concept central du dispositif, auquel le texte se réfère de nombreuses fois.

Le risque est défini comme la combinaison entre la probabilité qu’un dommage survienne et la gravité de ce dommage.

C’est sur cette base que les systèmes d’IA seront classifiés dans différentes catégories de risques dans le reste du texte.

Maintenant que nous savons quels types de systèmes sont concernés par l’AI Act, intéressons-nous aux acteurs concernés par cette régulation et aux phases du cycle de vie durant lesquelles ils sont impliqués.

III. Quels sont les acteurs concernés par l’IA Act, et à quel moment ?

L’un des points essentiels de l’AI Act est la définition claire des responsabilités selon le rôle joué par chaque entité dans le cycle de vie d’un système d’IA. Le texte distingue principalement quatre types d’acteurs qui doivent respecter certaines obligations en fonction de leur niveau d’intervention sur le système.

1. Le provider (fournisseur)

Il s’agit de toute personne physique ou morale qui développe un système d’IA ou qui le fait développer pour le commercialiser ou le mettre à disposition (gratuitement ou non), sous son propre nom ou sa propre marque.

Par exemple, une entreprise qui conçoit et déploie un système d’IA afin d’optimiser son service après-vente en interne ou qui le commercialise à ses clients pour leurs besoins de service après-vente est considérée comme provider.

2. Le deployer (utilisateur)

Le deployer est toute personne physique ou morale qui utilise un système d’IA dans un cadre professionnel ou organisationnel, c’est-à-dire dans un but autre que purement personnel.

C’est le cas d’une entreprise qui souscrit à une solution d’IA pour gérer son recrutement ou ses ventes.

À noter : si le deployer apporte des modifications au système (par exemple via un fine-tuning) ou appose sa propre marque au système, il bascule dans le rôle de provider, avec les obligations correspondantes.

3. L’importer

L’importer est une entité basée dans l’UE qui met sur le marché européen un système d’IA développé en dehors de l’Union et le fait sous la marque d’un fournisseur non-européen.

Ce rôle implique également des responsabilités de conformité, notamment s’assurer que le système respecte les exigences prévues par l’AI Act avant sa mise sur le marché.

4. Le distributeur

Mentionné aussi dans le texte, le distributeur est une entité qui rend un système d’IA disponible sur le marché européen sans en être le développeur, ni l’importateur, ni le fournisseur. Cela peut inclure par exemple une marketplace ou un revendeur SaaS.

Et qu’en est-il des entreprises non-européennes ?

Il est important de noter que l’AI Act a une portée extraterritoriale. Toute entreprise, même établie hors UE, est concernée par le texte dès lors que :

-

son système d’IA est utilisé dans l’Union européenne, ou

-

les outputs du système ont un impact sur des citoyens européens.

Autrement dit, un système d’IA développé à l’étranger, mais utilisé par une entreprise européenne ou ayant des effets mesurables dans l’UE (par exemple, une plateforme de contenu génératif), entre dans le champ d’application de la réglementation.

Une responsabilité partagée tout au long du cycle de vie

Enfin, il est important de souligner que les obligations ne sont pas limitées à la phase de mise sur le marché. Le texte de loi insiste sur le fait que la conformité s’applique tout au long du cycle de vie du système, ce qui inclut les mises à jour, les modifications fonctionnelles et même les changements dans les conditions d’utilisation.

IV. L’approche de catégorisation par niveau de risque

Maintenant que nous savons quels types de systèmes sont concernés par l’AI Act et quels sont les rôles des différents acteurs impliqués, il est temps de se pencher sur un aspect central de cette régulation : le système de catégorisation par niveau de risque.

Le principe est simple : pour chaque système d’IA, il est nécessaire d’évaluer le risque que son utilisation fait peser sur la santé, la sécurité et les droits fondamentaux des citoyens européens. C’est ce niveau de risque qui détermine les obligations réglementaires à respecter, tant pour le provider que pour le deployer.

Il est important de noter que le niveau de risque repose non pas sur la technologie utilisée, mais sur le cas d’usage du système, donc sur la manière dont il peut impacter les citoyens européens. Ce point est important car il permet au texte de loi de rester pertinent, même face à l’émergence de nouvelles approches technologiques.

Ainsi, un système d’IA, même très basique, utilisé pour évaluer des citoyens à des fins de social scoring sera considéré comme à risque inacceptable. Tandis qu’un système d’IA utilisant un modèle avancé (par exemple un LLM) pour générer des designs de jeu vidéo pourra être classé comme à risque minimal.

Voyons quels sont les 4 niveaux de risques définis par l’AI Act :

Risque Inacceptable

• Social scoring

• Profilage

• Inférence des émotions sur le lieu de travail

• Exploiter des vulnérabilités de personnes

• Signaux subliminaux pour manipuler le comportement

Risque Élevé

• Biométrie

• Recrutement

• Accès aux services essentiels

• Justice et maintien de l’ordre

• Immigration

• Processus démocratique

Risque Modéré

• Chatbot

• Génération de contenu

• Recommandation

Risque Faible

• Filtre anti-spam

• Classification de photos personnelles

• Recommandation de playlist

1. Risque inacceptable (prohibé)

Ce niveau de risque est attribué aux systèmes d’IA dont le cas d’usage présente une menace manifeste pour la santé, la sécurité et les droits fondamentaux des citoyens européens. L’article 5 du texte de loi définit des guidelines afin de savoir quels types de systèmes entrent dans cette catégorie. Notamment :

-

les systèmes qui exploitent des vulnérabilités de personnes ou de groupes de personnes (enfants, personnes âgées, handicapées);

-

les systèmes qui utilisent des signaux subliminaux pour manipuler le comportement;

-

les systèmes de social scoring;

-

les systèmes de profilage;

-

les systèmes d’inférence des émotions sur le lieu de travail, entre autres.

Les systèmes classés dans cette catégorie de risque sont tout simplement interdits, de déploiement (par des deployers) et d’utilisation (par des providers).

2. Risque élevé (réglementé)

Les systèmes classés à haut risque posent un danger potentiel important, mais acceptable s’ils respectent un ensemble strict d’obligations techniques, organisationnelles et documentaires.

Deux cas sont principalement concernés :

-

Les systèmes d’IA intégrés à des produits relevant de réglementations sectorielles existantes (ex. : dispositifs médicaux, véhicules autonomes) et jouant un rôle de composant de sûreté.

-

Les systèmes utilisés dans l’un des 8 domaines critiques listés en annexe III du texte de loi, parmi lesquels :

-

Biométrie

-

Recrutement et gestion du personnel

-

Accès à l’éducation, aux services essentiels ou aux aides sociales

-

Justice et maintien de l’ordre

-

Contrôle des frontières et immigration

-

Processus démocratique

-

Les providers et deployers de ces systèmes doivent se conformer à une série d’exigences : gestion des risques, documentation, transparence, auditabilité, cybersécurité, gouvernance des données, etc.

Sans respect de ces obligations, le système ne pourra pas être mis sur le marché ou utilisé dans l’UE.

3. Risque modéré (transparence renforcée)

Les systèmes à risque modéré ne présentent pas de menace directe pour les droits fondamentaux, mais peuvent néanmoins influencer le comportement ou les décisions des utilisateurs.

Ce sont notamment les systèmes destinés à interagir avec des individus comme les chatbots ou les outils de génération de contenu ou de recommandation.

Ils sont principalement soumis à des obligations de transparence.

4. Risque minimal ou faible (non réglementé)

Enfin, la catégorie de risque le plus faible concerne les systèmes qui ne posent pas de risque significatif pour les droits fondamentaux des citoyens et ne sont donc pas soumis à des exigences spécifiques au titre de l’AI Act.

Ce sont par exemple les systèmes de classification de photos personnelles, de recommandations de playlists musicales ou de filtre anti-spam d’une boîte mail.

Pour autant, même pour ces systèmes, les bonnes pratiques restent recommandées, notamment en matière de transparence, de robustesse et d’éthique.

V. Timeline d’application de l’AI Act et sanctions en cas de non-conformité

Maintenant que nous avons vu les grands principes de régulation de l’AI Act, voyons quand les différentes réglementations entreront en vigueur et à quelles sanctions s’exposent les acteurs qui ne s’y conforment pas.

L’AI Act a été adopté formellement par le Parlement européen le 13 mars 2024 et est entré en vigueur le 1er Août 2024. Le texte ne s’appliquera pas immédiatement dans sa globalité.

-

2 Février 2025 : les systèmes à risque inacceptable sont interdits

-

2 Août 2025 : les règles relatives aux GPAI modèles, à la gouvernance et à la confidentialité s’appliquent

-

2 Août 2026 : le reste du texte de loi entre en application, sauf pour les systèmes à risque élevé

-

2 Août 2027: la réglementation pour les systèmes à risque élevé s’applique.

Sanctions en cas de non-conformité

L’AI Act prévoit un régime de sanctions proportionné au niveau de gravité de la non-conformité. Les amendes peuvent s’élever jusqu’à 35 millions d’euros ou 7% du chiffre d’affaires annuel mondial.

VI. Organisation des instances chargées d’appliquer l’AI Act

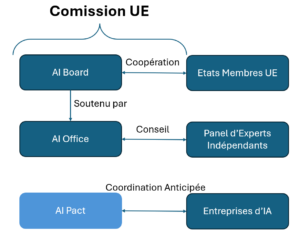

Pour garantir une application cohérente et harmonisée de l’AI Act à travers toute l’Union européenne, plusieurs instances de gouvernance ont été prévues par le règlement. Chacune d’entre elles joue un rôle spécifique dans la supervision, la coordination, le conseil ou encore le suivi du développement de l’IA.

Nous avons tout d’abord l’AI Office (au sein de la Commission européenne). C’est l’acteur central du dispositif. Son rôle est de superviser la mise en œuvre générale du texte de loi, de suivre l’évolution des GPAI modèles, mais aussi d’émettre des lignes directrices et des clarifications sur l’interprétation du texte et de sanctionner les systèmes non conformes (avec un pouvoir direct de contrôle et d’enquête).

Il est aussi chargé de collaborer avec les autorités nationales et les autres instances européennes, notamment sur les cas transfrontaliers.

L’AI Board ou Comité européen de l’IA, regroupe les représentants des autorités compétentes de chaque État membre. Il permet notamment d’assurer une application uniforme de l’AI Act dans toute l’UE, de coordonner les autorités nationales (équivalent des CNIL locales) et d’émettre des avis techniques et de partager les bonnes pratiques.

Le Panel d’experts indépendants rassemble des experts scientifiques, techniques, juridiques et éthiques en IA. Son rôle est de donner un avis indépendant sur certains systèmes ou modèles, de contribuer à l’évaluation des GPAI et d’alerter sur de nouveaux risques technologiques ou sociétaux. Leur avis n’est pas juridiquement contraignant, mais il peut fortement influencer les décisions de l’AI Office.

Avant même l’entrée en vigueur du texte, la Commission a lancé une initiative nommée ‘AI Pact”. Cette initiative non contraignante permet aux entreprises qui le souhaitent de s’engager de manière anticipée dans la conformité à l’AI Act et de contribuer aux bonnes pratiques en matière d’IA responsable.

C’est une manière pour les organisations d’amorcer leur transformation réglementaire tout en échangeant avec les régulateurs.

En conclusion

L’AI Act marque un tournant dans la manière dont l’intelligence artificielle est pensée, développée et utilisée au sein de l’Union européenne. En tant que data scientists, nous ne sommes plus uniquement des acteurs techniques : nous devenons aussi des garants de conformité, de transparence et d’éthique.

Comprendre les fondamentaux de cette nouvelle réglementation, identifier les rôles et responsabilités qui en découlent, intégrer la logique de gestion des risques dans nos projets… autant de réflexes à adopter dès maintenant pour anticiper sereinement les prochaines échéances.

Dans le prochain article, nous nous pencherons sur les obligations qui incombent à un provider — un rôle qui englobe notamment celui de développeur — dans le cadre des systèmes d’IA à haut risque, soit la catégorie soumise aux exigences les plus strictes. Nous verrons comment adapter concrètement notre workflow de Data Science pour y intégrer les bonnes pratiques nécessaires à la conformité et ainsi contribuer à des systèmes d’IA plus durables et dignes de confiance.

Recent Comments